前言

最近,DeepSeek 的热度一路飙升,成为了全球 AI 科技圈中的一颗新星。作为一款能够高效处理海量数据、快速生成优质信息的 AI 工具,它在中文处理上的优异表现与其低廉的价格让国内外无数开发者和企业惊叹不已,甚至还让 ChatGPT 也追随它的脚步新增了相似的“搜索”和“推理”功能。

随着使用者的增加,很多用户不再满足于手机、网页的简单使用,而是想进一步利用 DeepSeek 为自己的工作提供帮助,因此本篇文章就来与大家探讨一下——如何将 DeepSeek 部署在本地服务器中,以便更好地掌控数据和功能。

相信我,DeepSeek 的本地部署步骤比你想象的,还要简单。

推荐阅读

- AI 聊天工具 ChatGPT 详细测评使用教程合集(DeepSeek 崩了就用 ChatGPT 代替)

- 5 款 AI 英语对话陪练工具推荐

- 6 款 AI 角色扮演网站推荐

- 8 款 AI 论文查重降重工具推荐

- 6 款 AI 编程工具推荐

- 10 款 AI 智能翻译工具推荐

- 7 款 AI 小说朗读软件推荐

- 6 款 AI 字幕生成软件推荐

本地部署是什么?

什么是“本地部署”呢?本地部署意味着将软件安装在自己的本地的服务器或计算机上,而不依赖于外部云服务,简单来说就相当于软件的安装,区别只是这里是安装模型,并且所需的硬件要求要更高,并且步骤稍微复杂一点。这种方式不仅让你能在私有环境中运行DeepSeek,还能大幅提升数据隐私和操作灵活性。

本地化部署 DeepSeek 的好处

- 更高的数据安全性:数据永远保存在自己的硬盘里,无需担心云端泄露的风险。

- 完全掌控:你可以自己定制和优化系统,随时调整 DeepSeek 的设置,完全根据自己的需求来操作。

- 独立运行:不依赖外部网络环境,减少了系统故障和外部攻击的风险,也不用再忍受 DeepSeek 的“服务器繁忙,请稍后再试”。

- 灵活扩展:可以根据需要升级硬件或修改部署设置,完全符合自身发展节奏。

DeepSeek 模型性能对比

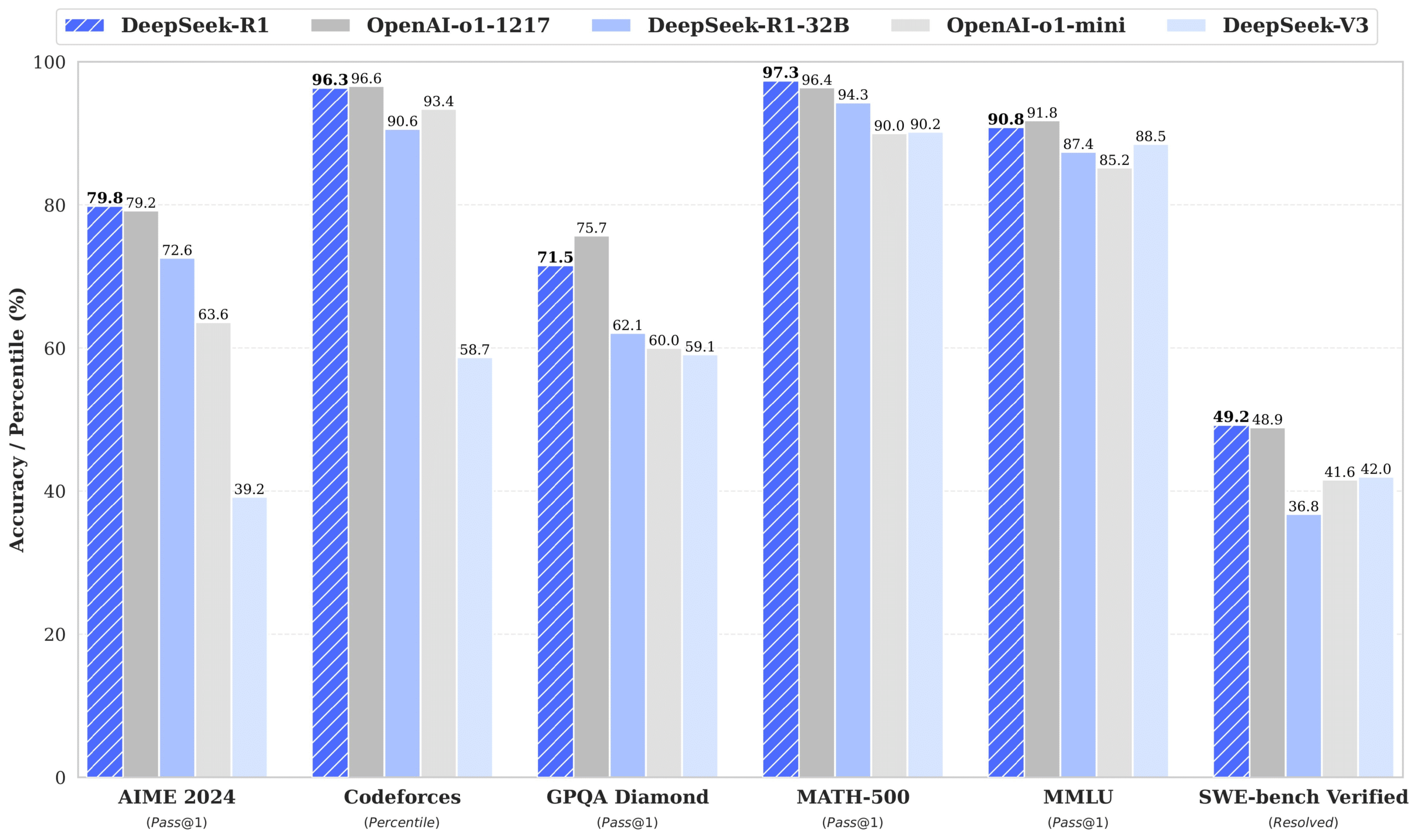

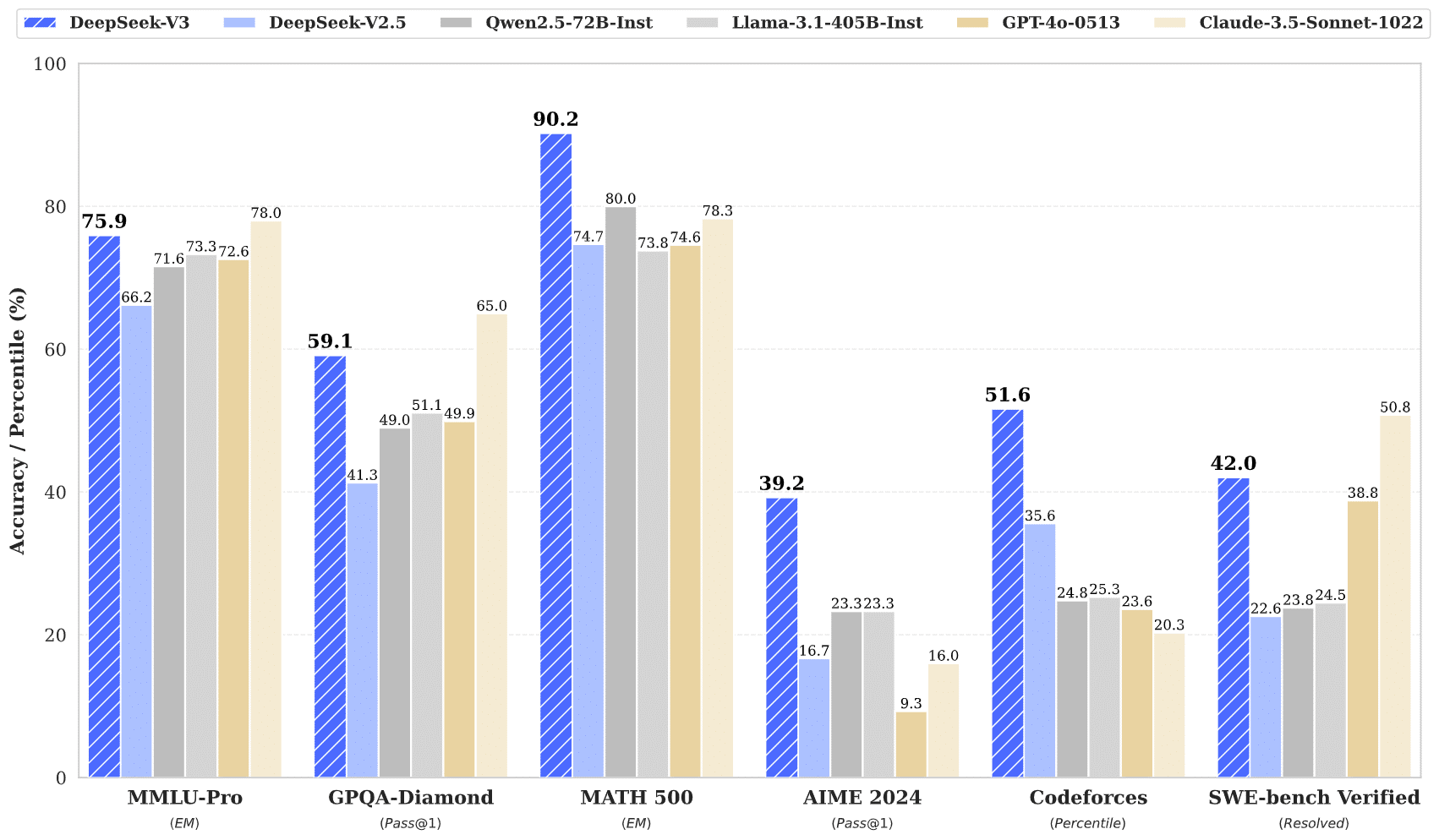

DeepSeek 常用的两种模型分别是 DeepSeek R1 和 DeepSeek V3,这两种模型侧重点不同,部署的硬件要求也不尽相同,先来让我们看一下它们的功能对比:

DeepSeek R1

- 定位:通用型大语言模型(LLM),面向多场景、多任务的智能化需求。

- 特点:

- 更强的通用性和泛化能力,适用于开放域问答、文本生成、代码编写等多种任务。

- 支持更长的上下文窗口,能够处理更复杂的对话和长文本分析。

- 在自然语言理解(NLU)和生成(NLG)方面表现优异,适合需要高交互性和创造力的场景。

- 适用场景:内容创作、智能客服、软件编程、教育辅导等。

DeepSeek V3

- 定位:垂直领域优化模型,专注于特定行业或任务的高精度需求。

- 特点:

- 针对特定领域(如金融、医疗、法律等)进行了深度优化,具备更强的领域知识理解能力。

- 在特定领域的任务上有着更高的准确性和效率。

- 模型规模更小,部署和推理成本相对较低。

- 适用场景:金融风控、医疗诊断、法律咨询等垂直领域。

大家在完成日常的生成任务时一般更适合使用 DeepSeek V3,因为它的综合能力更强,适合多样化的创作、生成任务,不过也因为该模型的泛用性强,导致它本地部署的硬件要求远高于适合特定的垂直领域的 DeepSeek R1,所以综合考虑成本,大部分人的选择依然是硬件要求低、成本低廉的 DeepSeek R1。

不过不用担心 R1 在日常任务上的的生成表现不佳,DeepSeek R1 官方对标 OpenAI 最新模型 o1 正式版,并且网页、手机版 DeepSeek 的“深度思考”功能便是通过 R1 来完成的,因此我们可以放心使用 R1 来完成日常生成任务,尤其是在对成本控制有着较高要求的情况下。

本地化部署 DeepSeek 的硬件要求

先让我们来看一下 DeepSeek R1 和 DeepSeek V3 两种模型的硬件要求对比,表里列的都是所需最低的硬件要求,若你的硬件条件不够,就无法本地部署这些模型了。

R1 最低等级模型可纯 CPU 部署,而 V3 则需 GPU 加速部署。

| 模型 | DeepSeek-R1 | DeepSeek-V3 |

|---|---|---|

| CPU | Intel i5-8400 / AMD Ryzen 5 2600(4 核 8 线程,支持 AVX2 指令集) | Intel Xeon Silver 4310(12 核以上)或同级别 AMD 处理器 |

| 内存 | 8 GB+ | 128GB DDR4(支持 GPU 数据交换) |

| 存储 | 3 GB+ | 1TB NVMe SSD(RAID 0 阵列优先) |

| GPU | 非必须 | NVIDIA A10(24GB 显存,支持 FP16 推理) |

| 显存 | GTX 1650 | 单卡需 ≥80GB 显存(FP32 模式,非量化场景) |

V3 的硬件要求过高,若要实现部署成本显然偏高,且日常使用的电脑不太可能带得动,非常不适合适合普通人应用,因此本篇文章接下来将着重介绍更具性价比的 DeepSeek R1 更细致的硬件条件要求和本地化部署教程。

DeepSeek R1 详细硬件要求

此表依旧列出了每种模型最低的硬件要求。

| 模型型号 | CPU | 内存 | 硬盘 | 显存 | 适用场景 |

|---|---|---|---|---|---|

| DeepSeek-R1-1.5B | 4 核 | 8 GB+ | 3 GB+ | 非必需(若需 CPU 加速可选 GTX 1650) | 个人使用,如笔记本电脑、台式电脑等 |

| DeepSeek-R1-7B | 8 核 | 16 GB+ | 8 GB+ | 8 GB+显存(如 RTX 3070/4060) | 中小型企业本地开发 |

| DeepSeek-R1-8B | 8 核(需略高于 7B 10%-20%) | 16 GB+ | 8 GB+ | 8 GB+显存 | 中小型企业本地开发(提升精度的轻量级任务) |

| DeepSeek-R1-14B | 12 核 | 32 GB+ | 15 GB+ | 16 GB+显存(如RTX 4090 或 A5000) | 中小型企业本地开发(中量级任务) |

| DeepSeek-R1-32B | 16 核 | 64 GB+ | 30 GB+ | 24 GB+显存(如 A100 40 GB 或 RTX 3090) | 专业领域任务,如医疗、科研、法律 |

| DeepSeek-R1-70B | 32 核 | 128 GB+ | 70 GB+ | 多卡并行(如 2x A100 80GB 或 4x RTX 4090) | 大型企业或科研机构,专业领域任务处理 |

| DeepSeek-R1-671B(满血版) | 64 核 | 512 GB+ | 300 GB+ | 多卡并行(如 8x A100/H100) | 国家级科研任务处理 |

普通人的考虑范围大概在 1.5b-14b 之间,可以看具体的硬件条件挑选适合的模型。另外,在这些模型中只有 1.5b 支持纯 CPU 部署,因此如果你没有 GPU,那么直接选 1.5b 即可。设备好一点,可以选 7B 甚至 14B。

DeepSeek R1 本地化部署流程

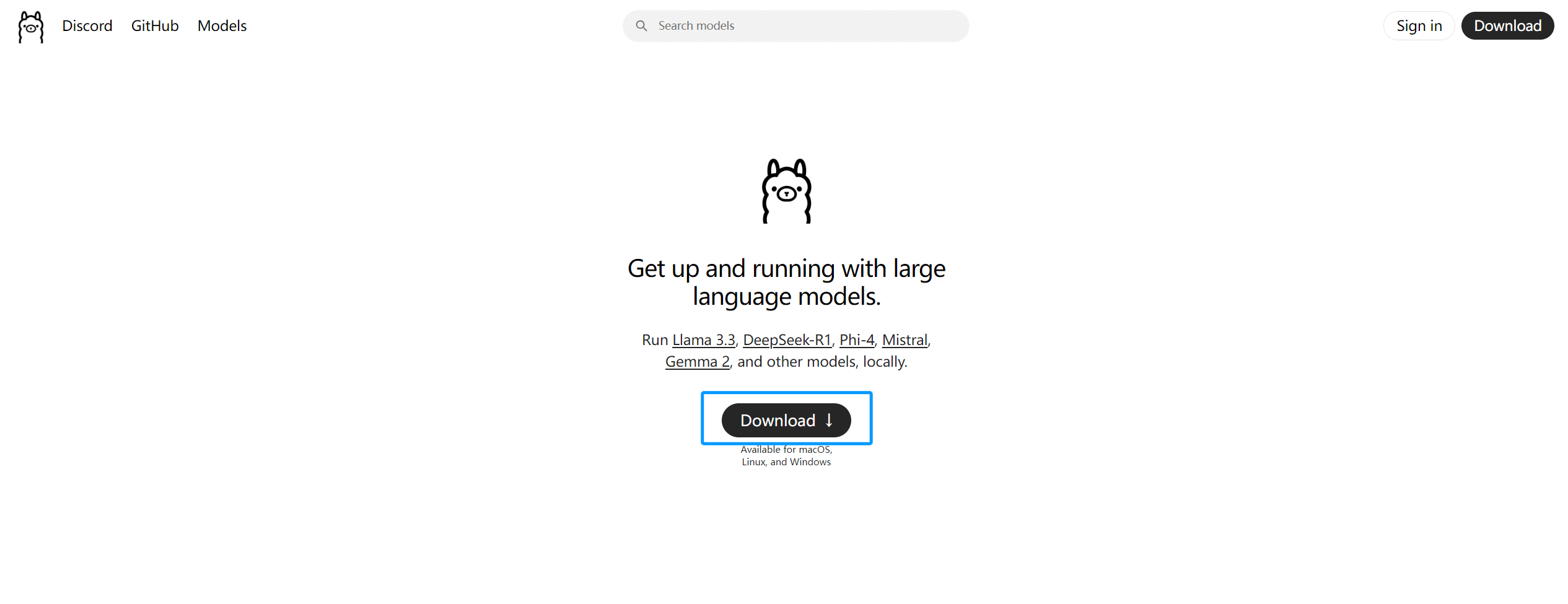

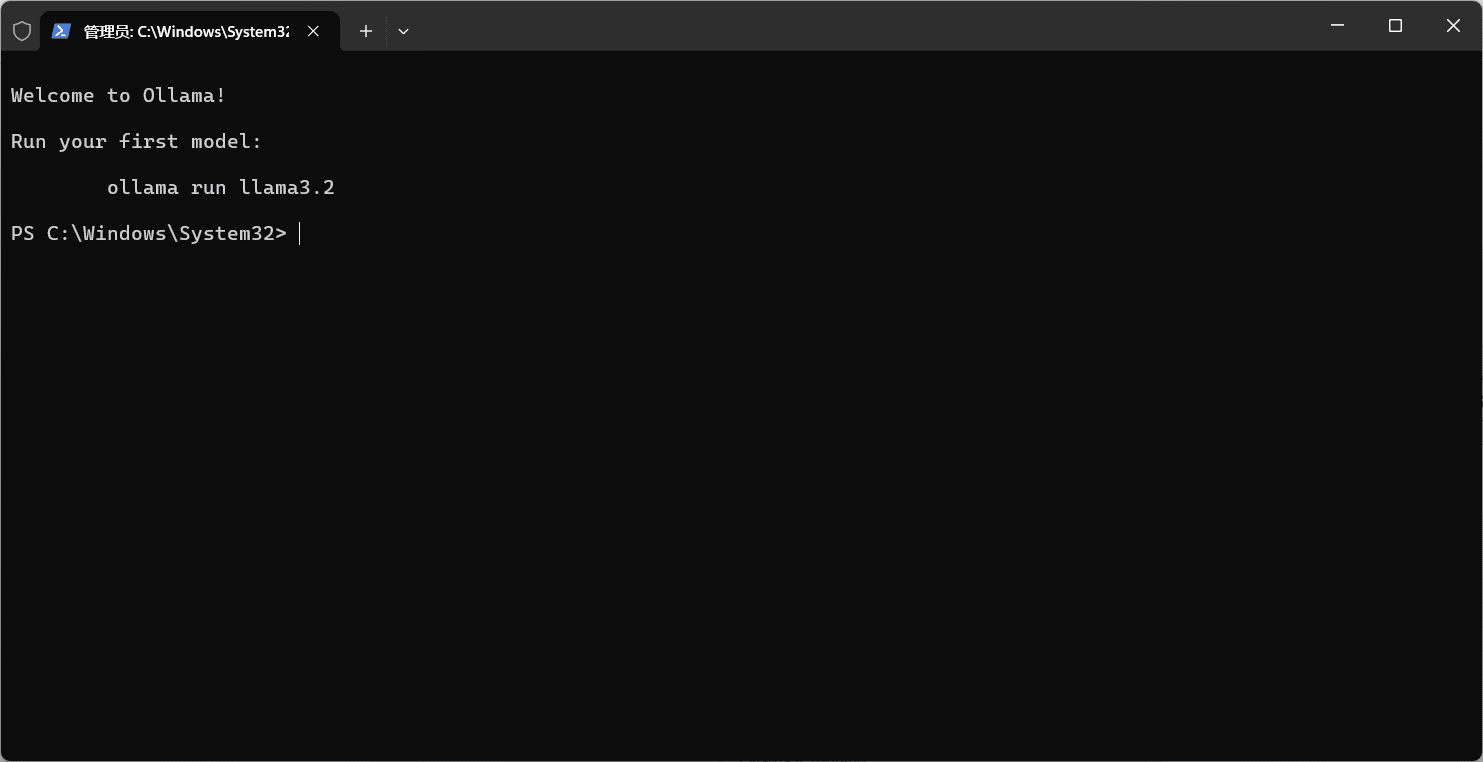

1、安装 Ollama

Ollama 是一个可以让你使用并管理 AI 模型的工具,相当于 R1 的承载器具,因此我们在本地部署模型前必须先安装 Ollama。

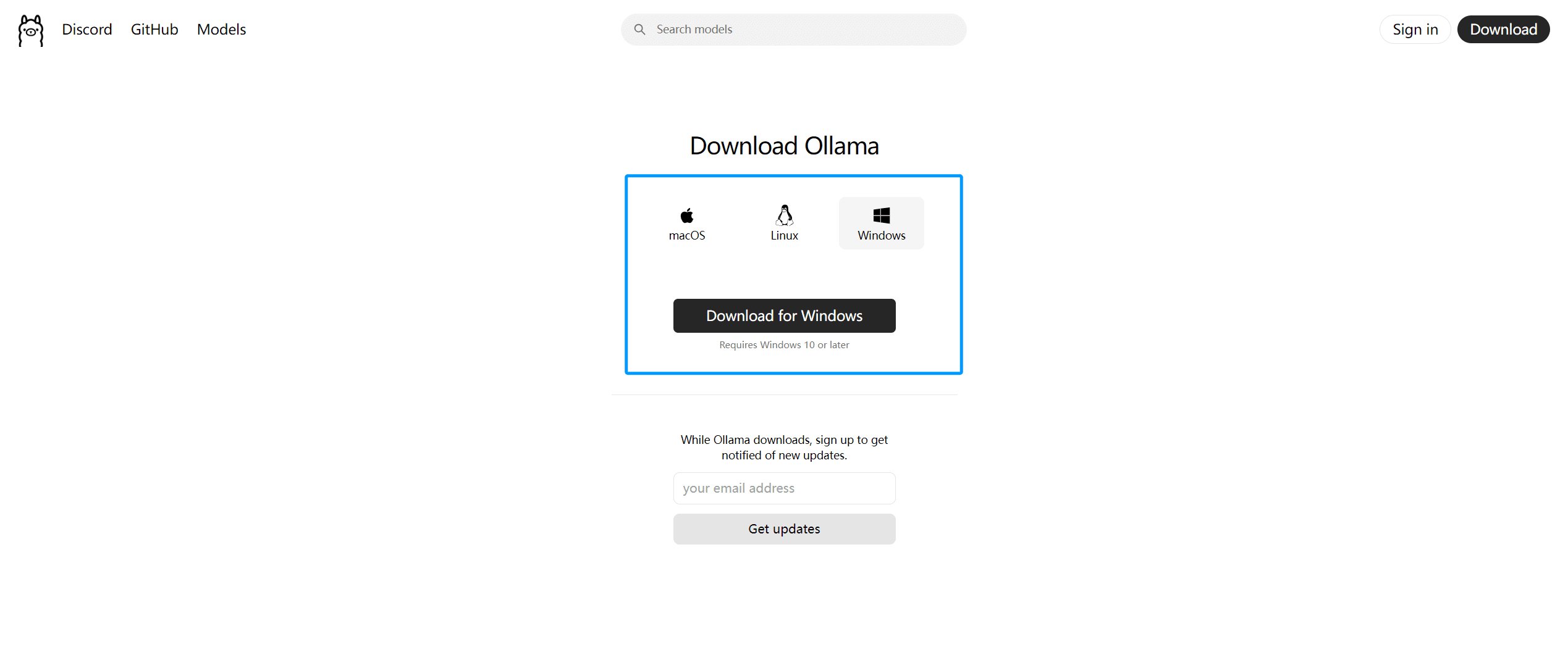

打开 Ollama 官网,点击“Download”。

选择适合你电脑的版本,例如“Windows”点击“Download for Windows”。

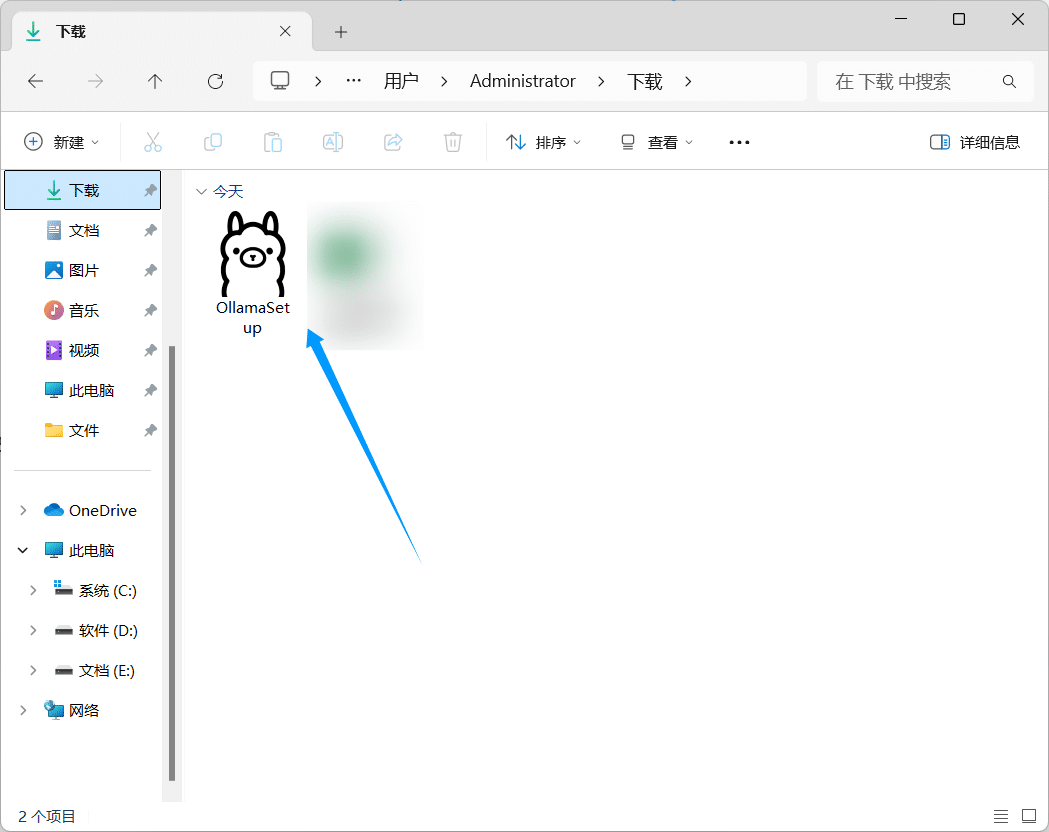

安装包共 745 MB,下载完后双击这个羊驼(OllamaSetup)。

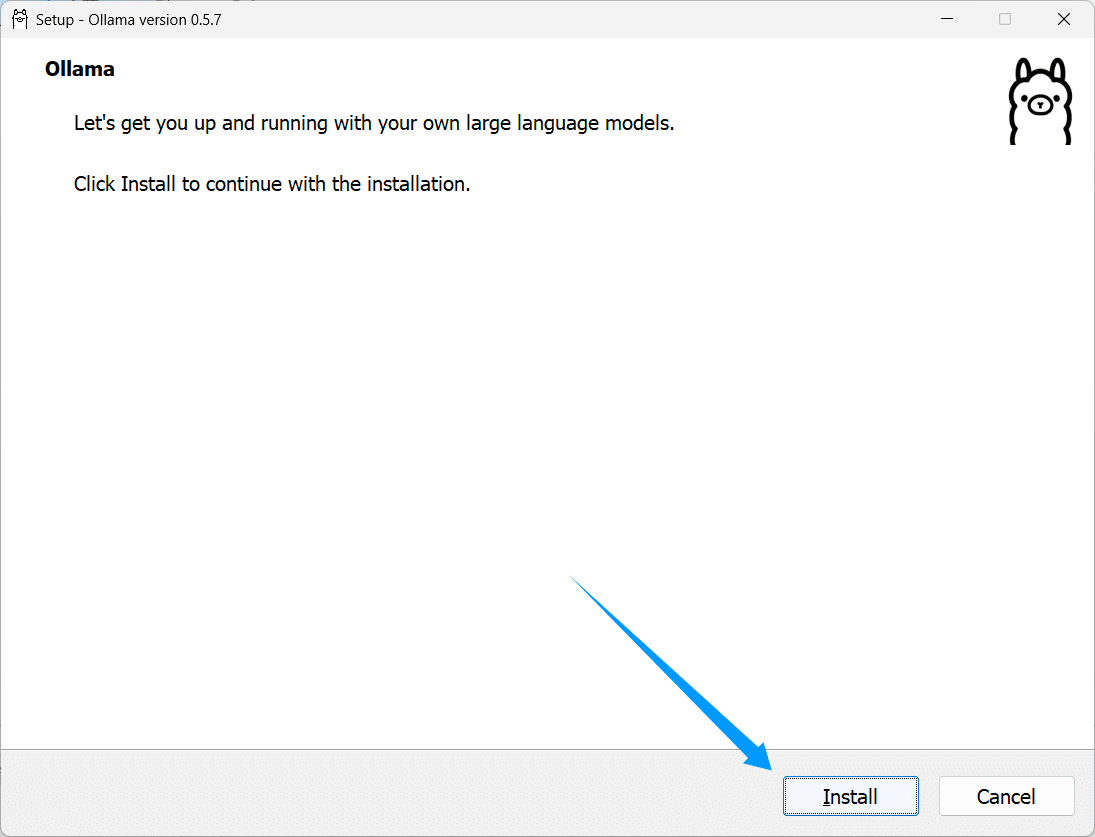

点击“Install”后等待安装。

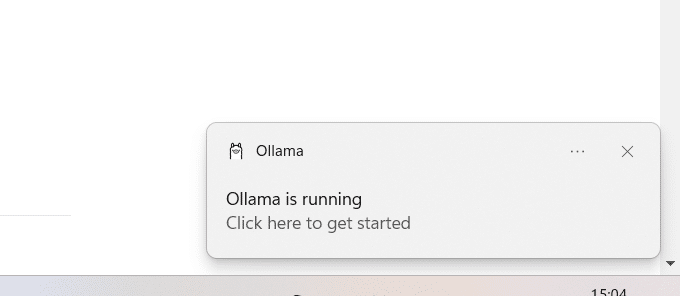

安装完成后电脑右下角会弹出一个小弹窗,点击它就能开始运行。

如果错过了这个小弹窗,可以点击 Win 键,在搜索框中输入“Cmd”,然后将“ollama -v”输入到“C:\Users\Administrator>”的后方,点击回车即可,成功后会显示“Ollama version is 0.5.7”。

2、下载并部署 DeepSeek R1

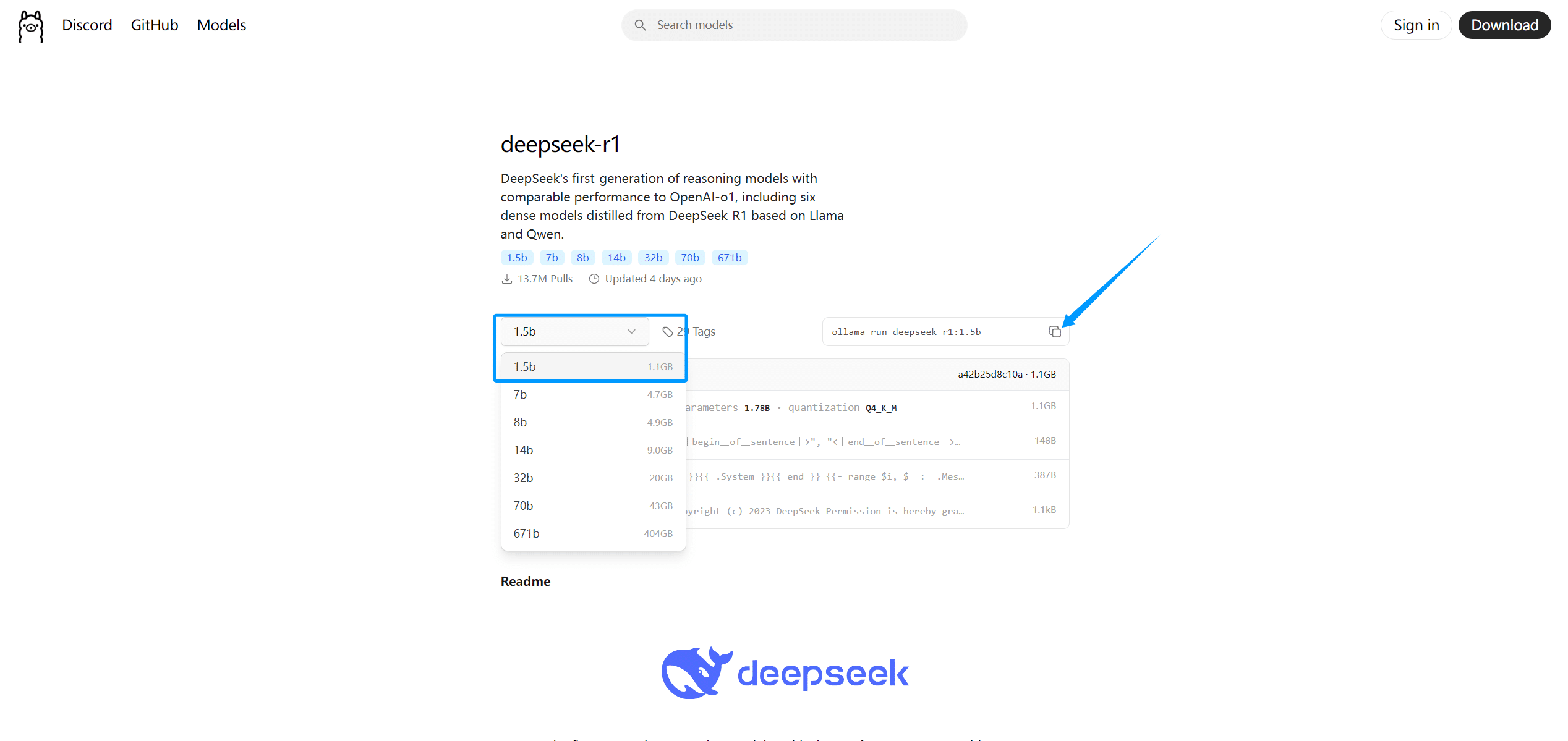

再次打开 Ollama 官网,在顶部搜索栏粘贴“DeepSeek R1”搜索,点击第一个结果,单机下拉框选择需要下载的模型,下图以 1.5b 为例,选择好后点击右边的复制按钮。

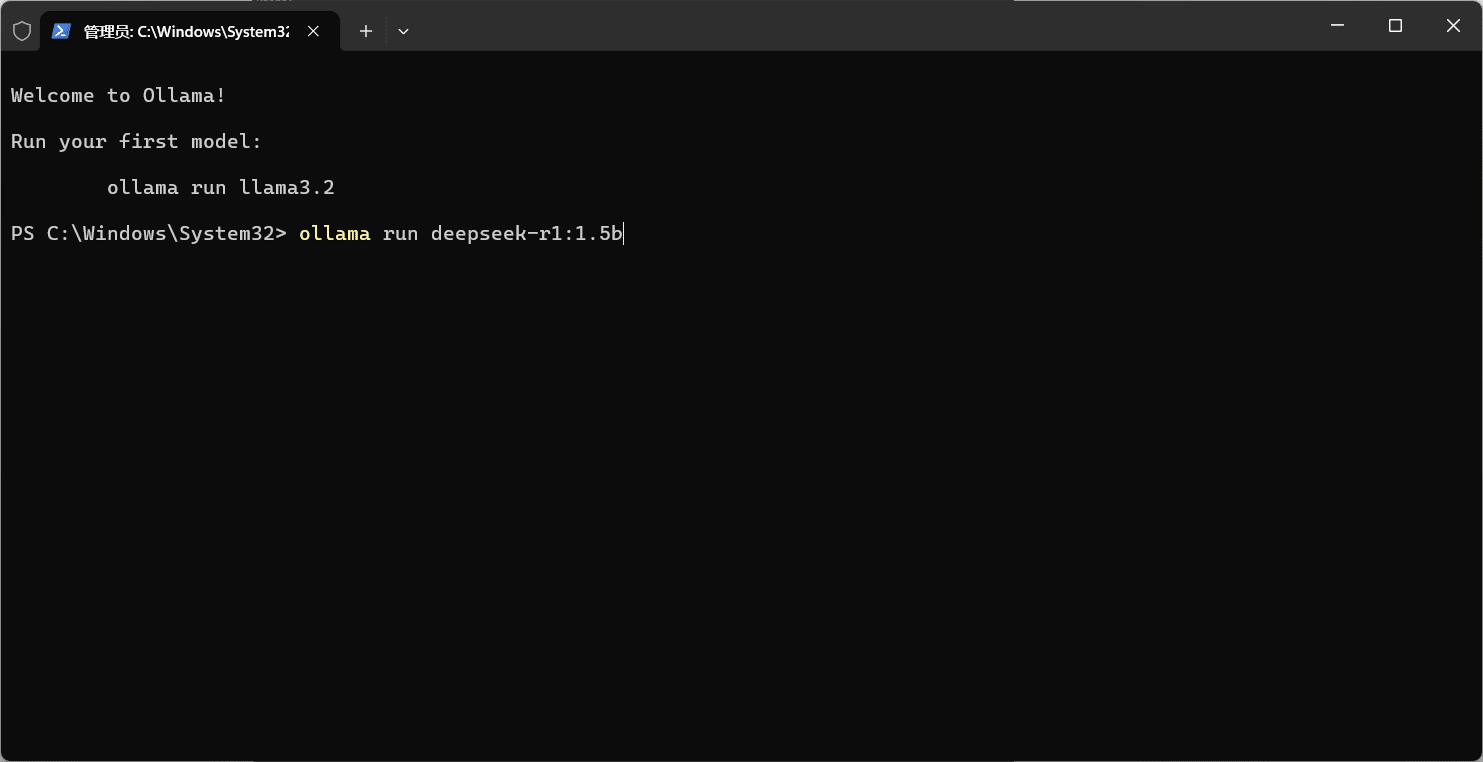

将复制的命令粘贴到刚刚的窗口中,点击回车键。

出现了“Success”就是按部署成功啦,接下来直接向它提问就可以了。

下次再用依然是点击 Win 键,在搜索框中输入“Cmd”,然后将“ollama run deepseek-r1:1.5b”(如果你下的是 7b,就将命令后面的 1.5b 改成 7b)输入到“C:\Users\Administrator>”的后方,点击回车即可。

结语

那么本地部署的教程到这里就结束了,是不是比想象中的还要简单呢。如果你嫌弃现有的使用窗口不够美观、便捷,想拥有如同 DeepSeek 网页版那样的使用体验,那就还可以找一些支持加载本地模型的可视化工具搭配使用(例如 AnythingLLM),不过这并不是必需的,看个人需求。